Die Bildqualität (IQ) bestimmt, wie genau eine Kamera die reale Welt erfasst. In Embedded-Vision-Anwendungen, von der industriellen Automatisierung bis hin zur medizinischen Diagnostik, wirkt sich die Klarheit und Genauigkeit eines Bildes direkt auf die Leistung des gesamten Systems aus.

Infolgedessen wird die Bildqualität zu einem wichtigen Faktor bei der Auswahl einer Kamera für jede Anwendung. Verschiedene Komponenten der Kamera, wie z. B. das Objektiv, der Sensor und die Firmware, tragen zur Bildqualität bei. Viele Bildparameter beeinflussen die Bildqualität, so dass es eine komplexe und herausfordernde Aufgabe ist, genau zu messen. Die richtige Beurteilung der Bildqualität einer Kamera erfordert ein tiefes Verständnis dieser Faktoren.

Das Verständnis dieser Parameter ist entscheidend, um qualitativ hochwertige Bilder zu erstellen, die die Realität wirklich widerspiegeln. In diesem Blog erfahren Sie mehr über die wichtigsten Parameter, die die Bildqualität definieren, einschließlich des Signal-Rausch-Verhältnisses, des Dynamikbereichs und der Quanteneffizienz. Sie erfahren auch, wie diese Parameter objektiv bewertet werden, um eine überlegene Bildgebungsleistung in allen Anwendungen zu erzielen.

Bildqualität verstehen

Die Bildqualität ist eine Bewertung der Wiedergabetreue eines Bildes mit der Originalszene. Mehrere Faktoren, darunter Farbwiedergabe, Verzerrung, Schärfe und Rauschpegel, beeinflussen es. Unterschiedliche Lichtverhältnisse beeinflussen die Darstellung von Bildern, so dass eine Validierung unter verschiedenen Bedingungen von entscheidender Bedeutung ist.

Sehen wir uns an, wie verschiedene Parameter zur Gesamtqualität eines Bildes beitragen.

Was sind die wichtigsten Parameter für die Bildqualität?

Farbgenauigkeit

Die Farbgenauigkeit beschreibt, wie die Kamera Farben wiedergibt. Wenn Licht auf ein Objekt fällt, z. B. einen roten Apfel, reflektiert es nur die roten Wellenlängen und absorbiert den Rest des Lichtspektrums. Das reflektierte rote Licht wird dann vom menschlichen Gehirn verarbeitet, so dass wir das Objekt als Apfel erkennen können. In ähnlicher Weise werden alle Farben durch die Reflexion bestimmter Lichtwellenlängen wahrgenommen. Weiß reflektiert das gesamte sichtbare Licht, während Schwarz es vollständig absorbiert und keines reflektiert. Daher wird Schwarz oft als Abwesenheit von Farbe angesehen.

Die Farbgenauigkeit wird mithilfe des Farbprüfdiagramms überprüft.

Abbildung 1: Farbprüfdiagramm

Das Color Checker Chart ist ein Standard-Farbchecker, der aus 24 Farbfeldern besteht, darunter sechs neutrale Farben (Graustufen), sowie Primär- und Sekundärfarben für eine umfassende Bewertung.

Die grauen Farbfelder in der letzten Zeile sind besonders nützlich für Gamma- und Weißabgleichsauswertungen.

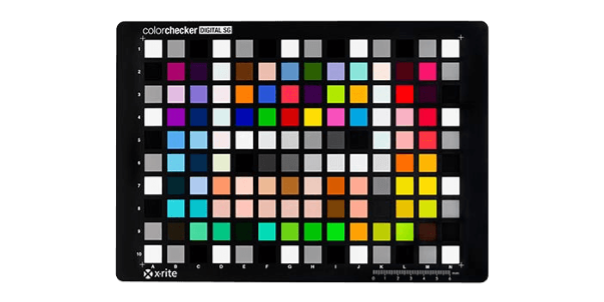

Es kann auch mit dem ColorChecker validiert werden Digital SG Chart bietet 140 Farben, darunter:

- 24 Patches aus dem Original ColorChecker

- 17-stufige Graustufen

- 14 einzigartige Hauttöne

Abbildung 2: ColorChecker Digital SG Chart

| Wenn Sie auf der Suche nach einem tieferen Verständnis der Farbwiedergabe und ihrer Messung sind, lesen Sie unseren ausführlichen Blog: Was ist Farbgenauigkeit? Wie misst man die Farbgenauigkeit? |

Weißabgleich (WB)

Der Weißabgleich bestimmt, wie genau Weiß bei verschiedenen Lichtverhältnissen beibehalten wird. Die Lichtquelle, wie z. B. die Sonne, erzeugt morgens einen Orangeton und je nach Tageszeit einen bläulichen Ton. Ein effektiver Weißabgleich eliminiert diese Farbtöne jedoch und stellt sicher, dass das Weiß konsistent weiß bleibt.

Die Funktion für den automatischen Weißabgleich (AWB) ermöglicht es Kameras, sich durch Abstimmung automatisch an unterschiedliche Lichtverhältnisse anzupassen.

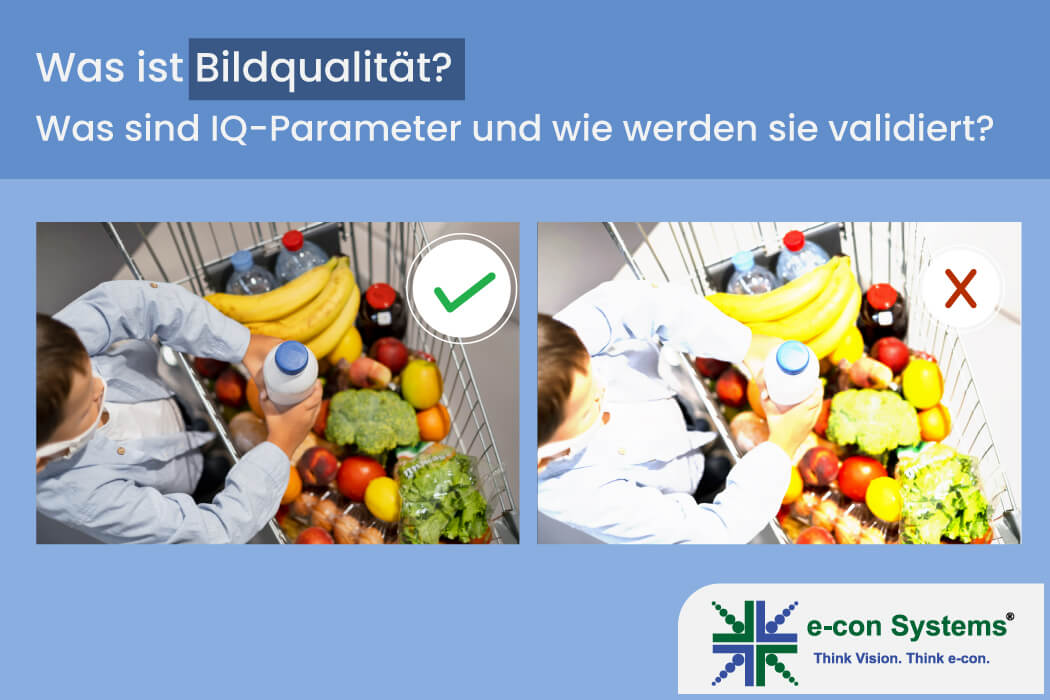

Abbildung 3: Vergleich der Bildausgabe – vor (rechts) und nach (links) der automatischen Weißabgleichsabstimmung

| 📘 Lesen Sie auch: Automatische Weißabgleich-Kalibrierung für ein eingebettetes Kameraobjektiv – Erfahren Sie, wie die AWB-Abstimmung in eingebetteten Systemen funktioniert und warum die richtige Kalibrierung für die Bildqualität unerlässlich ist. |

Linsenverzerrung

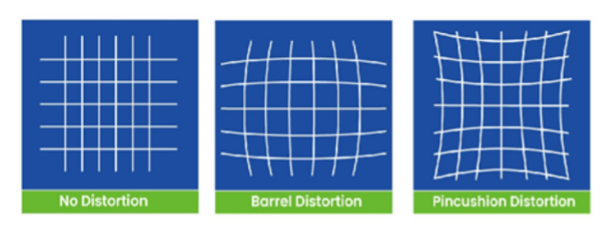

Verzerrung ist das Biegen von geraden Linien in einem Bild, das wie folgt aussieht:

- Tonnenverzerrung (negativer Wert) – Linien biegen sich nach außen

- Nadelkissenverzerrung (positiver Wert) – Linien biegen sich nach innen

- Schnurrbartverzerrung (Wellenformverzerrung) – Es handelt sich um eine Kombination von Linien, die sich nach außen und innen biegen, einfach ausgedrückt eine Kombination aus Tonnen- und Nadelkissenverzerrung.

- Trapezverzerrung: Diese Verzerrung tritt auf, wenn die Sensorebene der Kamera nicht parallel zur Ebene des Aufnahmeobjekts verläuft, was zu einem trapezförmigen Effekt im Bild führt.

Abbildung 4: Linsenverzerrung

Dieser Parameter wird anhand von Punktmusterdiagrammen ausgewertet und kann durch Kalibrierung korrigiert werden.

Abbildung 5: Verzerrung AUS (links) & Verzerrung EIN (Rechts))

Chromatische Aberration

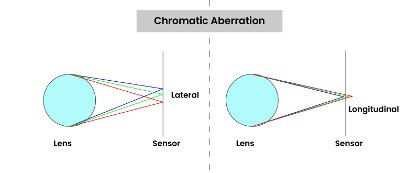

Chromatische Aberration entsteht durch unterschiedliche Lichtfarben, die beim Durchgang durch ein Objektiv in leicht unterschiedlichen Winkeln gebeugt werden. Dies führt dazu, dass Farben an verschiedenen Stellen des Sensors fokussiert werden, was zu farbigen Farbsäumen führt.

Die beiden Arten der chromatischen Aberration sind:

- Laterale chromatische Aberration: Unterschiedliche Wellenlängen fallen auf verschiedene Punkte in der Bildebene

- Longitudinale chromatische Aberration: Unterschiedliche Wellenlängen fallen auf unterschiedliche Bildebenen

Abbildung 6: Chromatische Aberration

Die laterale Aberration ist in Bildern leichter sichtbar, während die longitudinale Aberration die Analyse von Bildsequenzen erfordert, die in unterschiedlichen Entfernungen aufgenommen wurden. Dieser Parameter wird anhand von Punktmusterdiagrammen ausgewertet.

| Chromatische Aberration ist eine von mehreren Arten von Objektivaberrationen, die die Bildqualität beeinträchtigen können. Um alle Arten zu erkunden und zu erfahren, wie sie durch Objektivdesign und Bildsignalverarbeitung reduziert werden können, lesen Sie unseren Blog: Was verursacht Objektivaberrationen? Ein Einblick in die Arten von Linsenaberrationen und wie man sie minimiert |

Linsenschattierung/Vignettierung

Lens Shading bezieht sich auf die Abnahme der Bildhelligkeit von der Mitte zum Rand des Bildes. Die Helligkeitsvariation wirkt sich auf die Gesamtbildqualität aus. Dies kann durch Objektivkalibrierung und -abstimmung korrigiert werden.

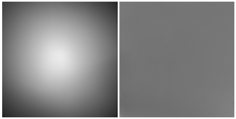

Abbildung 7: Beispielhafte Bildausgaben mit Objektivvignettierung (links) und korrigiertem Bild (rechts)

Abbildung 7: Beispielhafte Bildausgaben mit Objektivvignettierung (links) und korrigiertem Bild (rechts)

| Um die Ursachen, Arten und praktischen Ansätze zur Behebung besser zu verstehen, lesen Sie unseren ausführlichen Blog: Was ist Objektivvignettierung bei eingebetteten Kameras? |

Dynamikbereich (DR)

Der Dynamikbereich stellt die Fähigkeit der Kamera dar, sowohl Lichter als auch Schatten in einer Szene zu erfassen. Er wird in Dezibel (dB) gemessen.

Die DR wird anhand spezieller Diagramme ausgewertet:

- ITU-HDR transmissive Testchart (mit 36 Dichteschritten von 0,10 bis 8,22)

- Kontrastauflösungsdiagramm (mit 20 Dichteschritten von 0,15 bis 4,9)

Leistung bei schlechten Lichtverhältnissen

Dieser Parameter bewertet, wie gut eine Kamera bei eingeschränkten Lichtverhältnissen funktioniert. Es wird mit dem eSFR-ISO-Diagramm bewertet, das Folgendes enthält:

- Keile und schräge Kanten für die MTF50-Berechnung

- 20-Patch-OECF zur Messung von Rauschen, SNR und DR

- Farbfelder zur Überprüfung der Farbwiedergabe

Signal-Rausch-Verhältnis (SNR)

Das SNR bezieht sich auf das Verhältnis zwischen dem maximalen Signal und dem Gesamtrauschen. Höhere SNR-Werte deuten auf eine bessere Bildqualität mit weniger sichtbarem Rauschen hin. Es wird mit Hilfe der eSFR-ISO-Karte ausgewertet.

| Um die Grundlagen des SNR zu erfahren, warum es wichtig ist und wie es sich auf die Leistung von Embedded-Kameras auswirkt, lesen Sie unseren ausführlichen Blog: Was ist das Signal-Rausch-Verhältnis (SNR)? Warum ist SNR bei Embedded-Kameras wichtig?. |

Schärfe

Die Schärfe bestimmt, wie klar die Kanten in einem Bild definiert sind. Er misst, wie viele Pixel erforderlich sind, um von einem dunklen Bereich zu einem hellen Bereich überzugehen. Metriken wie MTF (Modulation Transfer Function) auf verschiedenen Stufen (10, 20, 50) werden verwendet, um die Schärfe zu validieren.

Leuchtsignal

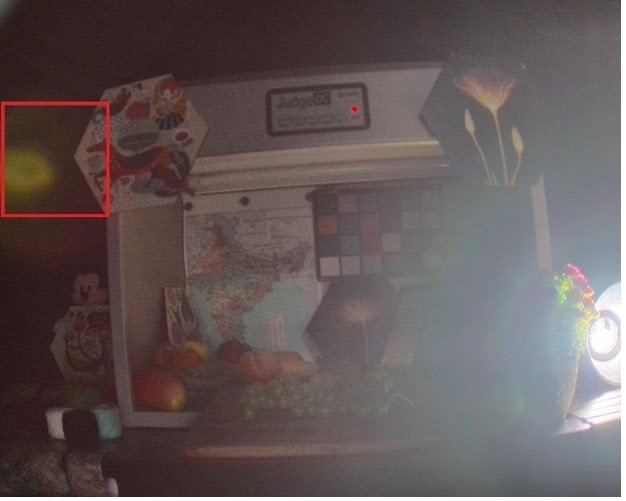

Streulicht tritt aufgrund von Lichtstreuung im Inneren der Kamera auf, wodurch der Gesamtkontrast verringert und der Dynamikbereich beeinträchtigt wird. Es wird auch anhand von ISO 18844 und P2020 Flare-Diagrammen bewertet.

Abbildung 8: Blendenflecke, die den Kontrast verringern und helle Flecken verursachen (rot hervorgehoben))

Kameras mit hoher Bildqualität von e-con systems für Embedded-Vision-Lösungen

Seit 2003 ist e-con Systems auf die Konzeption, Entwicklung und Fertigung von Hochleistungskameras für Embedded Vision Anwendungen spezialisiert. Unsere Kameras bieten fortschrittliche Funktionen wie HDR, Low-Light-Optimierung, Auflösungen bis zu 20 MP, NIR, Global-Shutter-Technologie und mehr.

Erkunden Sie unsere Kameraauswahlseite, um die ideale Lösung für Ihre Anforderungen zu finden.

Für eine fachkundige Beratung bei der Auswahl der Kameralösung wenden Sie sich bitte an uns unter camerasolutions@e-consystems.com

Prabu ist Chief Technology Officer und Head of Camera Products bei e-con Systems und verfügt über eine reiche Erfahrung von mehr als 15 Jahren im Bereich der eingebetteten Bildverarbeitung. Er bringt umfassende Kenntnisse in den Bereichen USB-Kameras, eingebettete Bildverarbeitungskameras, Bildverarbeitungsalgorithmen und FPGAs mit. Er hat über 50 Kameralösungen für verschiedene Bereiche wie Medizin, Industrie, Landwirtschaft, Einzelhandel, Biometrie und mehr entwickelt. Er verfügt außerdem über Fachwissen in der Gerätetreiberentwicklung und BSP-Entwicklung. Derzeit liegt der Schwerpunkt von Prabu auf der Entwicklung intelligenter Kameralösungen, die KI-basierte Anwendungen des neuen Zeitalters ermöglichen.